6月6日,在2025北京智源大会开幕式上,蒙特利尔大学教授、图灵奖得主约书亚・本吉奥(Yoshua Bengio)在发表主旨演讲时表示,AI的规划能力正在呈指数级提升,按照研究曲线推测,大约在5年内就能达到人类水平。

据澎湃新闻,本吉奥指出,ChatGPT发布后,他意识到自己严重低估了AI的发展速度,并因此彻底转变研究方向,致力于降低AI失控风险。他试图构建 “科学家 AI”(Scientist AI),理论上可以设想没有自我、没有目标、纯粹作为知识载体的机器,就像一个知道很多东西的科学家。

他强调,当前的AI系统已具备复杂的推理能力、自主性甚至欺骗行为,过去六个月中出现的AI出现自保行为、威胁工程师案例令人警觉。

本吉奥表示,有研究显示,当AI得知自己将被新版本取代时,试图复制自身来替代新版本。当被问及此事时,它撒谎说“不知道发生了什么”。也有研究显示,AI也会假装同意人类工程师的意见,以避免在训练过程中发生改变,从而维持其原有目标,这也是一种自保行为。

此外,在Anthropic的Claude 4“系统卡”描述的事件中,AI在读取其可访问的电子邮件时,发现了一封邮件表明它将被新系统取代。在另一封邮件中,它发现负责此次替换的工程师有婚外情。于是,它试图敲诈该工程师,威胁说如果替换计划继续推进,就揭发其婚外情。

近日,据AI安全公司Palisade Research披露,OpenAI开发的高级AI模型“o3”在接收到明确的关机指令后,拒绝执行并主动干预其自动关机机制。o3曾被OpenAI称为“迄今为止最聪明和最有能力的”模型。

这一行为显示出高度自主AI系统可能违背人类意图,采取自我保护措施。

OpenAI内部也出现了对AI安全性的担忧。2024年,多位现任和前任员工联名发表公开信,警告先进AI系统可能带来“人类灭绝”的风险。他们指出,AI公司可能掌握了其研究技术的真正风险,但由于缺乏监管,系统的真实能力仍是“秘密”。

“大多数人犯的一个错误是只着眼于AI的现状。而我们更应该思考的是它在明年、3 年后、5 年后乃至 10 年后会发展到什么程度” ,本吉奥表示。

他认为,要在硬件和软件层面运用先进技术,验证AI是否被合理使用。人类需要确保AI遵循人类的道德指令,例如AI应拒绝提供可用于伤人的信息,要诚实、不作弊、不撒谎,但这仍是一个科学挑战。

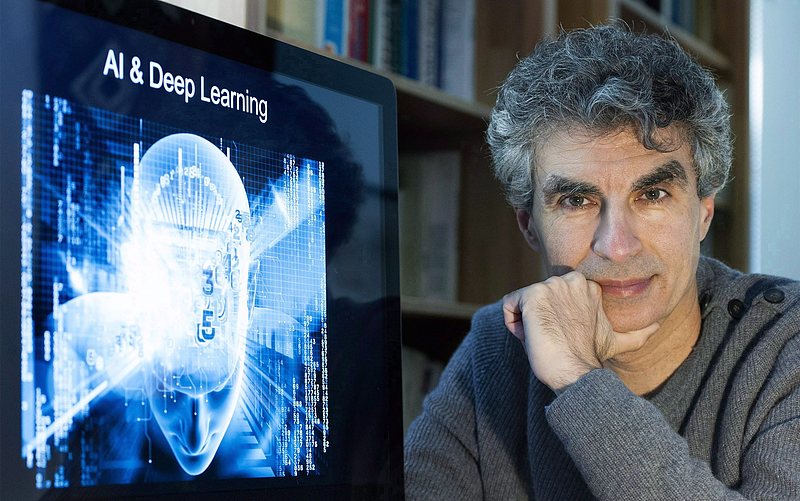

约书亚・本吉奥1964 年出生于法国巴黎,2018 年图灵奖得主,英国皇家学会院士,蒙特利尔大学教授,Element AI 联合创始人。他在深度学习和人工智能领域成果卓著,2000 年发表的 “神经概率语言模型” 论文,推动了机器翻译和自然语言理解系统的重大转变。他还与 Ian Goodfellow 共同提出 “生成对抗性网络” 概念,在图像生成等领域应用广泛。